AI Agent 算法工程师学习路线图(研究型)

目标岗位:AI Agent 算法工程师(研究/创新型)学习时长:9 周(全职投入)最终产出:1-2 个算法创新型项目 + 1 篇高质量论文/高星开源项目

一、你能获得什么

二、算法岗核心要求

你需要具备的能力

理论深度

- 能徒手推导核心算法

- 精通背后数学原理

- 掌握领域前沿论文

- 能设计创新性算法 | 实验能力

- 设计严谨的对比实验

- 设计全面的消融实验

- 选择有说服力的 Baseline

- 科学分析与验证指标提升 | 产出能力

- 撰写高质量学术论文

- 开源高影响力代码

- 撰写专业技术报告

- 为顶级算法库贡献代码 |

算法岗简历必备

三、推荐学习资源与工具

📚 核心课程与书籍

- 课程: 《动手学深度学习》 - 深度学习基础的最佳入门

- 课程: 清华大模型公开课第二季 - 系统了解大模型历史与前沿

- 课程: Stanford CS224N: NLP with Deep Learning - NLP经典课程

- 书籍: 《大语言模型》 - 大模型最佳中文书籍

- 书籍: 《Build a Large Language Model (From Scratch)》 - 从零构建大模型

- 教程: 《动手学大模型Dive into LLMs》 - 上海交大编程实践教程(含PPT、视频)

- 教程: 《面向开发者的 LLM 入门教程》 - 吴恩达课程中文版

- 教程: 《从零开始的大语言模型原理与实践》 - Datawhale系统教程

📝 必读论文

- 基础: “Attention Is All You Need” - Transformer开山之作

- Agent: ReAct, Reflexion, Tree of Thoughts

- RL: DPO, GRPO, DeepSeek-R1

🛠️ 研究工具与框架

- 训练框架: LLaMA-Factory, TRL, OpenRLHF

- 微调教程: 大模型微调系列 - 从基础到实战的完整指南

- 评估工具: lm-evaluation-harness, OpenCompass, RAGAs

- Agent框架: LangChain, AutoGen, AgentScope

🌐 学习社区与资源

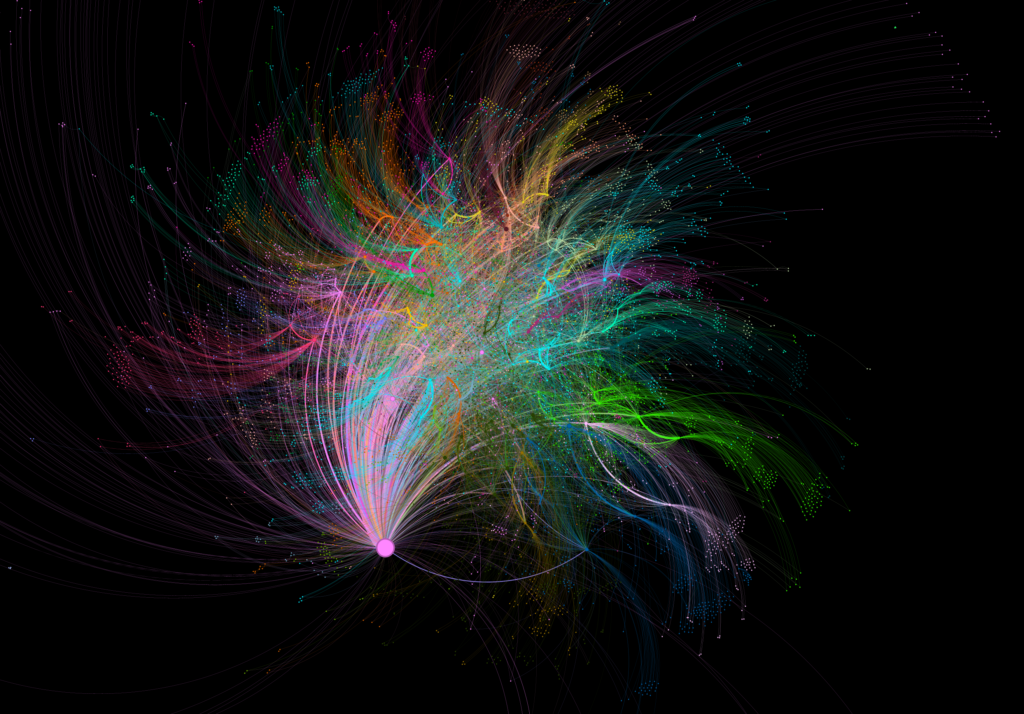

🎨 可视化学习资源(强烈推荐!)

- 100+ LLM/RL 算法原理图 ⭐ 算法岗必看!

- 作者:《大模型算法:强化学习、微调与对齐》作者余昌叶

- 内容:100+张原创算法原理图,涵盖Transformer、注意力机制、SFT、LoRA/QLoRA、DPO/PPO/GRPO、RLHF、推理优化等

- 价值:通过可视化图解深入理解算法的数学推导和实现细节,让复杂算法一目了然

- 书籍:《大模型算法:强化学习、微调与对齐》

四、详细学习计划

第 1 周:大模型必备基础 + 手撕Transformer

- Python 核心语法、NumPy/Pandas 基础

- 神经网络核心概念:前向传播、反向传播、损失函数

- PyTorch 框架速通:Tensor 操作、自动求导、模型搭建

- Transformer 架构详解:Encoder、Decoder 结构、Self-Attention 机制、Multi-Head Attention

- 核心组件剖析:Attention、Positional Encoding、Layer Normalization、残差连接、FFN

- MOE架构初探:专家网络、门控网络、Top-K激活

- PyTorch 手撕神经网络训练

- EXCEL实现Transformer矩阵计算

- 手撕 Multi-Head Attention

- 手撕 Transformer 关键模块

- 熟练运用 Python 和 PyTorch 进行开发

- 精通 Transformer 模型的核心架构与组件

- 具备手撕关键模块的能力

- 完全理解Bert、T5、GPT架构的工作原理

天数 | 学习主题 | 资源链接 | 目标 |

1 | Python & PyTorch 基础 | 掌握 Python 基础语法、PyTorch 张量操作与训练循环 | |

2 | 手撕神经网络训练 | 从零实现一个简单的前馈神经网络,理解反向传播 | |

3 | Transformer 宏观理解 | 掌握 Encoder/Decoder 结构、Multi-Head Attention | |

4 | Transformer 矩阵计算 | 逐个公式推导 Q/K/V 计算流程 | |

5 | 手撕 Multi-Head Attention | 纯 PyTorch 实现 Multi-Head Attention 和 FFN | |

6 | 手撕 Transformer 关键模块 | 组合已实现模块,完成一个完整的 Transformer Block | |

7 | MOE 架构与模型家族 | 理解 MOE 架构,并梳理 Bert、T5、GPT 架构的差异 |

第 2 周:Agent 核心理论 + ReAct 框架

- 什么是 AI Agent?

- Agent 的核心组件:Planning、Memory、Tool Use

- Agent vs. LLM vs. RAG 的本质区别

- ReAct 核心思想:Reasoning + Acting 交替进行

- ReAct (必读!): Agent 的 “Hello World” 论文:

arXiv.orgReAct: Synergizing Reasoning and Acting in Language Models

arXiv.orgReAct: Synergizing Reasoning and Acting in Language Models

ReAct: Synergizing Reasoning and Acting in Language Models

While large language models (LLMs) have demonstrated impressive capabilities across tasks in language understanding and interactive decision making, their abilities for reasoning (e.g....

- 阅读 ReAct 论文,手绘算法流程图

- 基于 LangChain 或 LlamaIndex 复现一个基础的 ReAct Agent

- Q: 请解释 ReAct 框架的工作原理。

- Q: ReAct 和传统的 Chain-of-Thought 有什么区别?

- 深刻理解 Agent 的基本工作范式

- 掌握 ReAct 框架的算法原理

天数 | 学习主题 | 资源链接 | 目标 |

8 | Agent 核心概念 | 建立 Agent 的宏观认知,理解其与 LLM 的区别 | |

9-10 | ReAct 论文精读与复现 | 深度理解 “Thought, Action, Observation” 循环,并用框架实现 | |

11-12 | ReAct 算法复现与思考 | 总结 ReAct 的优缺点,思考其在复杂任务中的局限性 | |

13-14 | 预留时间 & 周度复盘 | 巩固本周知识,完成所有编码任务 |

第 3 周:高级 Agent 架构:规划、反思与搜索

- Reflexion:自我反思机制

- Tree of Thoughts:树状思维搜索

- Self-Consistency:一致性采样

- Multi-Agent 通信协议与协作策略(辩论、投票、层级)

- 任务分解与分配算法

- Reflexion: 核心思想是通过自我反思改进决策。论文:

arXiv.orgReflexion: Language Agents with Verbal Reinforcement Learning

arXiv.orgReflexion: Language Agents with Verbal Reinforcement Learning

Reflexion: Language Agents with Verbal Reinforcement Learning

Large language models (LLMs) have been increasingly used to interact with external environments (e.g., games, compilers, APIs) as goal-driven agents. However, it remains challenging for these...

- Tree of Thoughts: 核心思想是搜索算法 + LLM。论文:

arXiv.orgTree of Thoughts: Deliberate Problem Solving with Large Language Models

arXiv.orgTree of Thoughts: Deliberate Problem Solving with Large Language Models

Tree of Thoughts: Deliberate Problem Solving with Large Language Models

Language models are increasingly being deployed for general problem solving across a wide range of tasks, but are still confined to token-level, left-to-right decision-making processes during...

- AutoGen Framework: 对话驱动的多智能体系统。论文:

arXiv.orgAutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation

arXiv.orgAutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation

AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation

AutoGen is an open-source framework that allows developers to build LLM applications via multiple agents that can converse with each other to accomplish tasks. AutoGen agents are customizable,...

- 对比 ReAct、Reflexion、ToT 的算法差异,分析各自优缺点

- 用 Python 实现一个 ToT 节点,并结合 LLM API 设计一个简单的评估函数来解决 24点游戏 问题

- 使用 AutoGen 框架实现一个简单的 “coder” 与 “critic” 协作的 Multi-Agent 系统

- Q: Reflexion 的自我反思机制如何实现?它和 RL 中的 “Credit Assignment” 有什么关系?

- Q: Tree of Thoughts 和传统 MCTS (蒙特卡洛树搜索) 的区别是什么?

- Q: 在 Multi-Agent 系统中,如何解决 “责任分散” 和 “目标冲突” 的问题?

- 掌握 Reflexion, ToT 等高级 Agent 架构的算法思想

- 能够分析不同 Agent 架构的优缺点和适用场景

- 理解多智能体系统的设计理念和协作模式

- 具备初步设计复杂 Agent 系统的能力

天数 | 学习主题 | 资源链接 | 目标 |

15 | Reflexion 论文精读 | 掌握其”Actor -> Evaluator -> Self-Reflection”的算法流程 | |

16 | Reflexion 算法分析 | 伪代码: Reflexion 官方伪代码

相关: Chain of Thought | 分析反思机制如何帮助 Agent 从失败中学习,并尝试用伪代码实现 |

17 | Tree of Thoughts 论文精读 | 理解如何将 LLM 作为搜索算法的启发式函数 | |

18 | ToT 算法实战 | 任务: 24点游戏

博客: Prompt Engineering Guide | 实现一个简化的 ToT 搜索策略来解决 24点游戏 |

19 | Multi-Agent 协作模式 | 学习 MetaGPT 中角色定义 (SOPs) 和协作模式 | |

20 | AutoGen 框架实战 | 使用 AutoGen 搭建一个简单的 Coder 和 Critic Agent | |

21 | 周度总结与对比分析 | 绘制 ReAct, Reflexion, ToT 的算法流程对比图,总结优劣 |

第 4 周:RAG 核心算法:从密集检索到图检索

- Naive RAG 的算法流程

- 检索算法:BM25、Dense Retrieval、Hybrid Search

- Reranker 算法原理

- GraphRAG 算法创新

- Agentic RAG 与多跳推理

- Dense Passage Retrieval (DPR): 现代 RAG 的基础,对比密集检索与稀疏检索。论文:

arXiv.orgDense Passage Retrieval for Open-Domain Question Answering

arXiv.orgDense Passage Retrieval for Open-Domain Question Answering

Dense Passage Retrieval for Open-Domain Question Answering

Open-domain question answering relies on efficient passage retrieval to select candidate contexts, where traditional sparse vector space models, such as TF-IDF or BM25, are the de facto method. In...

- GraphRAG: 基于知识图谱的检索,关注其子图采样、路径排序等创新。报告:

Microsoft ResearchProject GraphRAG - Microsoft Research

Project GraphRAG - Microsoft Research

LLM-Derived Knowledge Graphs GraphRAG (Graphs + Retrieval Augmented Generation) is a technique for richly understanding text datasets by combining text extraction, network analysis, and LLM prompting and summarization into a single end-to-end system. GraphRAG and LazyGraphRAG technology is now available through Microsoft Discovery (opens in new tab), an agentic platform for scientific research built in […]

- Self-RAG: 让 Agent 自主规划检索策略。论文:

arXiv.orgSelf-RAG: Learning to Retrieve, Generate, and Critique through...

arXiv.orgSelf-RAG: Learning to Retrieve, Generate, and Critique through...

Self-RAG: Learning to Retrieve, Generate, and Critique through...

Despite their remarkable capabilities, large language models (LLMs) often produce responses containing factual inaccuracies due to their sole reliance on the parametric knowledge they encapsulate....

- Python 手撕 BM25 算法

- 使用 FAISS 构建一个向量索引并进行相似度搜索

- 使用 RAGAs 或

trulens-eval对一个基础 RAG 系统进行评估

- 设计一个简单的 Agentic RAG 查询规划模块伪代码

- Q: GraphRAG 相比传统 RAG 的算法改进是什么?它适用于什么场景?

- Q: 如何设计一个 Agentic RAG 的规划策略?如何评估规划的好坏?

- Q: 密集检索和稀疏检索的优缺点分别是什么?为什么 Hybrid Search 通常效果更好?

- 深入理解现代 RAG 系统的检索算法基石

- 掌握 GraphRAG、Agentic RAG 等前沿 RAG 算法的创新点

- 具备手撕核心检索算法和评估 RAG 系统的能力

- 能够设计和评估 RAG 系统的检索模块

天数 | 学习主题 | 资源链接 | 目标 |

22 | 检索算法基础 (BM25) | 教程: BM25 from scratch

论文: TF-IDF | 理解 TF-IDF 和 BM25 的原理,并手动实现 |

23 | DPR 与密集检索 | 掌握双编码器架构,并使用 Sentence Transformers 训练一个模型 | |

24 | Reranker 与混合检索 | 理解 Reranker 的作用,并实现一个 BM25 + Embedding 的混合检索流程 | |

25 | GraphRAG 技术解读 | 理解其基于图的社群检测、摘要和问答流程 | |

26 | RAG 评估体系 | 学习 Faithfulness, Answer Relevancy 等 RAG 评估指标,并用 RAGAs 进行评估 | |

27 | Self-RAG 论文精读 | 学习如何通过 “reflection tokens” 让 LLM 自主决定何时检索、检索什么内容 | |

28 | Agentic RAG 算法设计 | 教程: Learn RAG From Scratch

课程: OpenRAG | 思考如何设计一个能进行多步推理的 Agentic RAG 策略,并绘制流程图 |

第 5 周:Agent Memory 与上下文工程算法

- 短期记忆 vs 长期记忆

- 记忆重要性评分算法 (语义相似度 + 任务相关性 + 时效性)

- 记忆压缩与总结策略 (聚类 + 摘要 + 去重)

- 记忆检索优化 (向量检索 + 时间衰减 + 重要性加权)

- 上下文选择策略 (语义相关性、逻辑依赖、时效性)

- 上下文压缩算法 (层级笔记、QA对转换、总结算法)

- 动态上下文构建

- Generative Agents: 经典的 Agent Memory 模拟社会行为研究。论文:

arXiv.orgGenerative Agents: Interactive Simulacra of Human Behavior

arXiv.orgGenerative Agents: Interactive Simulacra of Human Behavior

Generative Agents: Interactive Simulacra of Human Behavior

Believable proxies of human behavior can empower interactive applications ranging from immersive environments to rehearsal spaces for interpersonal communication to prototyping tools. In this...

- MemGPT: 通过分层记忆和函数调用管理虚拟上下文。论文:

arXiv.orgMemGPT: Towards LLMs as Operating Systems

arXiv.orgMemGPT: Towards LLMs as Operating Systems

MemGPT: Towards LLMs as Operating Systems

Large language models (LLMs) have revolutionized AI, but are constrained by limited context windows, hindering their utility in tasks like extended conversations and document analysis. To enable...

- 基于

MemGPT开源库,修改其配置以处理一个长文档问答任务

- 实现一个自定义的

NodePostprocessor(LlamaIndex) 来根据关键词或时间戳过滤上下文

- 设计一个分层记忆架构伪代码,包含评分、压缩、检索的完整 Agent Memory 算法方案

- Q: 如何设计 Agent 的长期记忆机制?请阐述其写入、更新、读取的全流程。

- Q: 记忆压缩和检索的trade-off如何平衡?如何通过实验评估你的压缩算法没有损失关键信息?

- Q: MemGPT 和传统的 RAG 在处理长上下文时有何本质区别?

- 掌握 Agent 记忆系统的核心算法设计

- 能够设计高效的上下文选择与压缩策略

- 理解如何平衡信息保真度与上下文长度的限制

- 具备从算法层面优化 Agent 长对话能力的视野

天数 | 学习主题 | 资源链接 | 目标 |

29 | Agent Memory 概述 | 梳理 Agent 记忆的分类和挑战 | |

30 | Generative Agents 论文精读 | 学习其对记忆进行评分 (Recency, Importance, Relevance) 和检索的机制 | |

31 | MemGPT 论文精读 | 学习其分层记忆和函数调用管理虚拟上下文的方法 | |

32 | MemGPT 实战 | 教程: MemGPT Tutorial

扩展: LangMem | 运行 MemGPT 官方示例,理解其工作流程 |

33 | 上下文压缩技术 | 学习并实现不同的上下文填充和压缩策略 | |

34 | 上下文选择与过滤 | 实现一个自定义的后处理器来优化上下文选择 | |

35 | 周度总结与方案设计 | ㅤ | 设计一个包含评分、压缩、检索的完整 Agent Memory 算法方案,并绘制架构图 |

第 6 周:基于强化学习的 Agent 决策优化

- RL 基础:MDP、Q-learning、Policy Gradient

- Agent + RL 的结合点

- 奖励函数设计 (稀疏奖励 vs 密集奖励, Reward Model)

- 策略优化算法 (PPO vs DPO vs GRPO)

- DPO: 无需显式奖励模型的偏好对齐方法。论文:

arXiv.orgDirect Preference Optimization: Your Language Model is Secretly a...

arXiv.orgDirect Preference Optimization: Your Language Model is Secretly a...

Direct Preference Optimization: Your Language Model is Secretly a...

While large-scale unsupervised language models (LMs) learn broad world knowledge and some reasoning skills, achieving precise control of their behavior is difficult due to the completely...

- GRPO: 最新的 RLHF 算法,核心思想是 Group Relative Policy Optimization,算法创新点在于相对偏好建模。论文:

arxiv.org

arxiv.org

- 推导 DPO 的损失函数

- 使用

TRL库中的DPOTrainer对一个 SFT 模型进行 DPO 微调

- 设计一个 Agent 工具调用任务的奖励函数

- Q: 如何用强化学习优化 Agent 的决策?请举例说明 State, Action, Reward 如何定义?

- Q: DPO 和 PPO 在 Agent 场景下的选择和优劣势是什么?为什么 DPO 更稳定?

- Q: 在一个稀疏奖励的 Agent 任务中(例如,只有任务最终成功才有奖励),如何设计 Reward Shaping 或辅助任务来帮助模型学习?

- 掌握将 Agent 决策过程建模为 RL 问题的能力

- 深刻理解 PPO/DPO/GRPO 等主流对齐算法的原理

- 能够为 Agent 任务设计合理的奖励函数

- 具备使用强化学习优化 Agent 策略的理论基础

天数 | 学习主题 | 资源链接 | 目标 |

36 | RL 基础入门 | 掌握 MDP, Policy, Value Function 等核心概念 | |

37 | Policy Gradient & PPO | 理解 PPO 的目标函数和裁剪机制 | |

38 | DPO 论文精读与推导 | 掌握 DPO 如何从偏好数据中隐式学习奖励并优化策略,并推导其损失函数 | |

39 | DPO 实战 | 使用 TRL 库完成一次 DPO 训练 | |

40 | GRPO 理论解读 | 理解 GRPO 如何将 DPO 扩展到组级别的偏好 | |

41 | RL for Tool Learning | 学习如何用 RL 思想让模型学会使用工具 | |

42 | 奖励模型设计 | 学习如何为 Agent 任务设计奖励函数/训练奖励模型 |

📚 核心学习资源推荐

精选业界最优质的学习资源,助你快速提升算法能力

🤖 智能体开发

- ⭐ 推荐指数: ★★★★★

- 📖 内容: Agent 开发完整教程,从基础到进阶

- 🎯 适合: 入门 Agent 算法开发,了解核心原理

- 💡 亮点: 中文友好、实战导向、Datawhale 出品

📊 RAG 算法优化

- ⭐ 推荐指数: ★★★★★

- 📖 内容: RAG 全流程算法优化,涵盖检索、重排、GraphRAG

- 🎯 适合: RAG 算法研究、检索优化、算法创新

- 💡 亮点: 系统化 RAG 教程、算法改进方向、实战案例

🔧 模型微调

- ⭐ 推荐指数: ★★★★★

- 📖 内容: 2-5倍微调加速,显存优化,支持 LoRA/QLoRA

- 🎯 适合: 高效微调、资源受限场景、快速实验

- 💡 亮点: 速度快、显存省、易上手

- ⭐ 推荐指数: ★★★★★

- 📖 内容: 支持100+ LLM微调,Web UI + CLI,SFT/DPO/PPO

- 🎯 适合: 算法实验、Function Call微调、模型对齐

- 💡 亮点: 功能全面、社区活跃、文档完善

🗃️ 数据处理

- ⭐ 推荐指数: ★★★★☆

- 📖 内容: 数据清洗、格式转换、质量评估

- 🎯 适合: 微调数据准备、数据质量提升

- 💡 亮点: 自动化数据处理、提升数据质量

🧠 从零构建大模型(理论深度)

- ⭐ 推荐指数: ★★★★★(算法岗必看)

- 📖 内容: 从零实现 GPT,代码简洁、注释详细

- 🎯 适合: 深入理解 Transformer、预训练原理

- 💡 亮点: Karpathy 亲自编写、500行核心代码、理解模型本质

- ⭐ 推荐指数: ★★★★★(算法岗必看)

- 📖 内容: 从零构建对话模型,涵盖训练、推理、部署

- 🎯 适合: 理解对话系统、端到端模型构建

- 💡 亮点: 完整的训练流程、实战导向、算法细节

🎯 完整学习路径

- ⭐ 推荐指数: ★★★★★

- 📖 内容: Agent 开发、RAG 系统、上下文工程、面试指南

- 🎯 适合: 系统化学习、求职准备、技术路线规划

- 💡 亮点: 算法岗/开发岗双路线、面试题库、简历模板

- 作者:Samuel Hu

- 链接:http://www.hjw-aihub.cn/technology/LLM-knowledge

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。